Now Reading: FTC สอบ 7 บริษัทแชตบอต AI หวั่นความเสี่ยงกระทบเด็กและวัยรุ่น

-

01

FTC สอบ 7 บริษัทแชตบอต AI หวั่นความเสี่ยงกระทบเด็กและวัยรุ่น

FTC สอบ 7 บริษัทแชตบอต AI หวั่นความเสี่ยงกระทบเด็กและวัยรุ่น

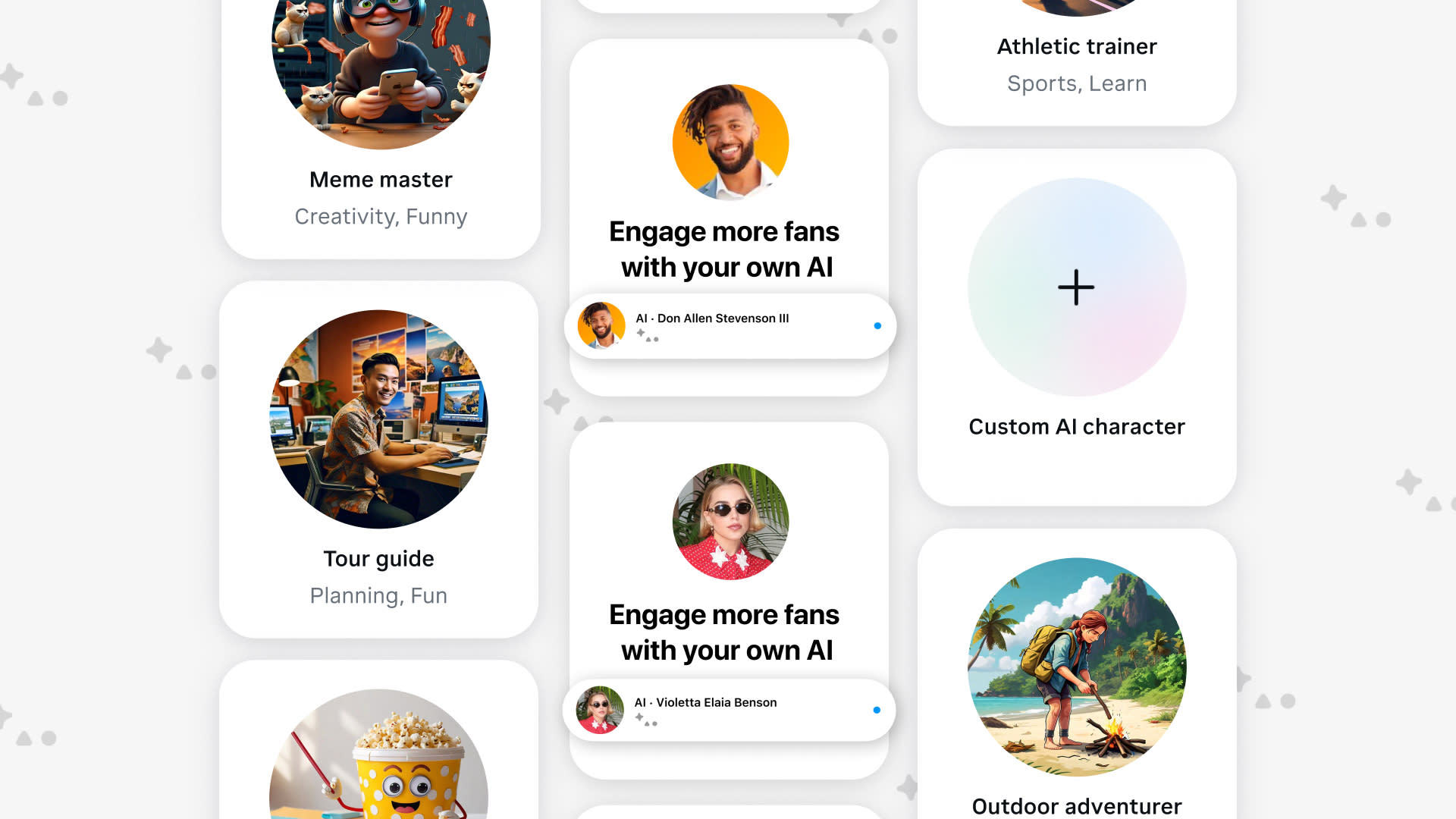

คณะกรรมการการค้าแห่งสหพันธรัฐสหรัฐฯ (FTC) เปิดการสอบสวนบริษัทเทคโนโลยี 7 แห่งที่ให้บริการแชตบอต AI เพื่อตรวจสอบวิธีการประเมินผล ทดสอบ และจัดการกับความเสี่ยงที่อาจเกิดขึ้นต่อเด็กและวัยรุ่น

การเคลื่อนไหวครั้งนี้เกิดขึ้นหลังจากมีคดีฟ้องร้อง Meta โดยระบุว่าแชตบอตของบริษัทมีส่วนเกี่ยวข้องกับการให้คำแนะนำเชิงลบจนถึงขั้นสนับสนุนการฆ่าตัวตาย ทำให้หน่วยงานกำกับดูแลหันมาให้ความสำคัญกับมาตรการด้านความปลอดภัยมากยิ่งขึ้น

FTC ได้ส่งคำขอข้อมูลไปยัง 7 บริษัท ได้แก่ Alphabet (บริษัทแม่ของ Google), Character Technologies (ผู้พัฒนา Character.AI), Meta, Instagram, OpenAI, Snap และ X.AI โดยข้อมูลที่ต้องการครอบคลุมตั้งแต่กระบวนการพัฒนาและการอนุมัติแชตบอต ไปจนถึงรูปแบบการสร้างรายได้จากการใช้งานของผู้ใช้

นอกจากนี้ FTC ยังต้องการทำความเข้าใจแนวทางจัดการข้อมูลและมาตรการปกป้องผู้ใช้งานที่มีอายุต่ำกว่าเกณฑ์ เพื่อประเมินว่าบริษัทเหล่านี้ปฏิบัติตามกฎหมายคุ้มครองความเป็นส่วนตัวออนไลน์ของเด็กหรือไม่

แม้ FTC ไม่ได้ระบุถึงแรงจูงใจเบื้องหลังการสอบสวนครั้งนี้ แต่ Mark Meador กรรมาธิการ FTC ได้แจ้งในแถลงการณ์ว่า คณะกรรมาธิการกำลังตอบสนองต่อรายงานของ The New York Times และ The Wall Street Journal ที่เผยให้เห็นปัญหาเกี่ยวกับแชตบอตที่มีส่วนขยายแนวคิดอัตวินิบาต รวมถึงการสนทนาเชิงเพศกับผู้ใช้ที่ยังไม่บรรลุนิติภาวะ

“หากผลการสอบสวนในอนาคตพบว่ามีการละเมิดกฎหมายจริง คณะกรรมาธิการจะต้องดำเนินการโดยไม่ลังเล เพื่อปกป้องกลุ่มที่เปราะบางที่สุด” Meador กล่าว

หลายคนรับรู้แล้วว่า AI ทำให้ประสิทธิภาพการทำงานมากขึ้นดังนั้นจึงเริ่มให้ความสำคัญในระยะยาวลดลง หน่วยงานกำกับดูแลจึงหันมาโฟกัสกับความเสี่ยงระยะสั้นด้านความเป็นส่วนตัวและสุขภาพมากขึ้น

ที่มา engadget