นักวิทยาศาสตร์จาก Icahn School of Medicine at Mount Sinai ได้พัฒนา AI ตัวใหม่ ที่สามารถวิเคราะห์ข้อมูลทางพันธุกรรมของมนุษย์ เพื่อค้นหาการกลายพันธุ์ของยีนที่อาจก่อให้เกิดโรค

AI7- Page

ความเคลื่อนไหวในวงการปัญญาประดิษฐ์ เอไอพัฒนาไปถึงขั้นไหน มีผลกระทบอย่างไร Ceei รวบรวมมาแล้ว

Zoom แพลตฟอร์มประชุมออนไลน์ชื่อดัง เปิดตัว “ผู้ช่วย AI” ให้สามารถใช้งานผ่านเว็บบราวเซอร์กันได้แล้ววันนี้ ซึ่งเป็นส่วนหนึ่งของ AI Companion 3.0 ช่วยสรุปประชุม, จดโน้ต และดึงข้อมูลเชิงลึกต่าง ๆ โดยสามารถใช้งานกับแพ็กเกจฟรีได้อีกด้วย สำหรับแพ็กเกจฟรี หรือ Basic Plan จะสามารถใช้ AI Companion ในการประชุมได้ 3 ครั้ง/เดือน โดยแต่ละครั้งจะมีฟีเจอร์สรุปการประชุม การถามคำถามระหว่างประชุม และการจดโน้ตด้วย AI นอกจากนี้

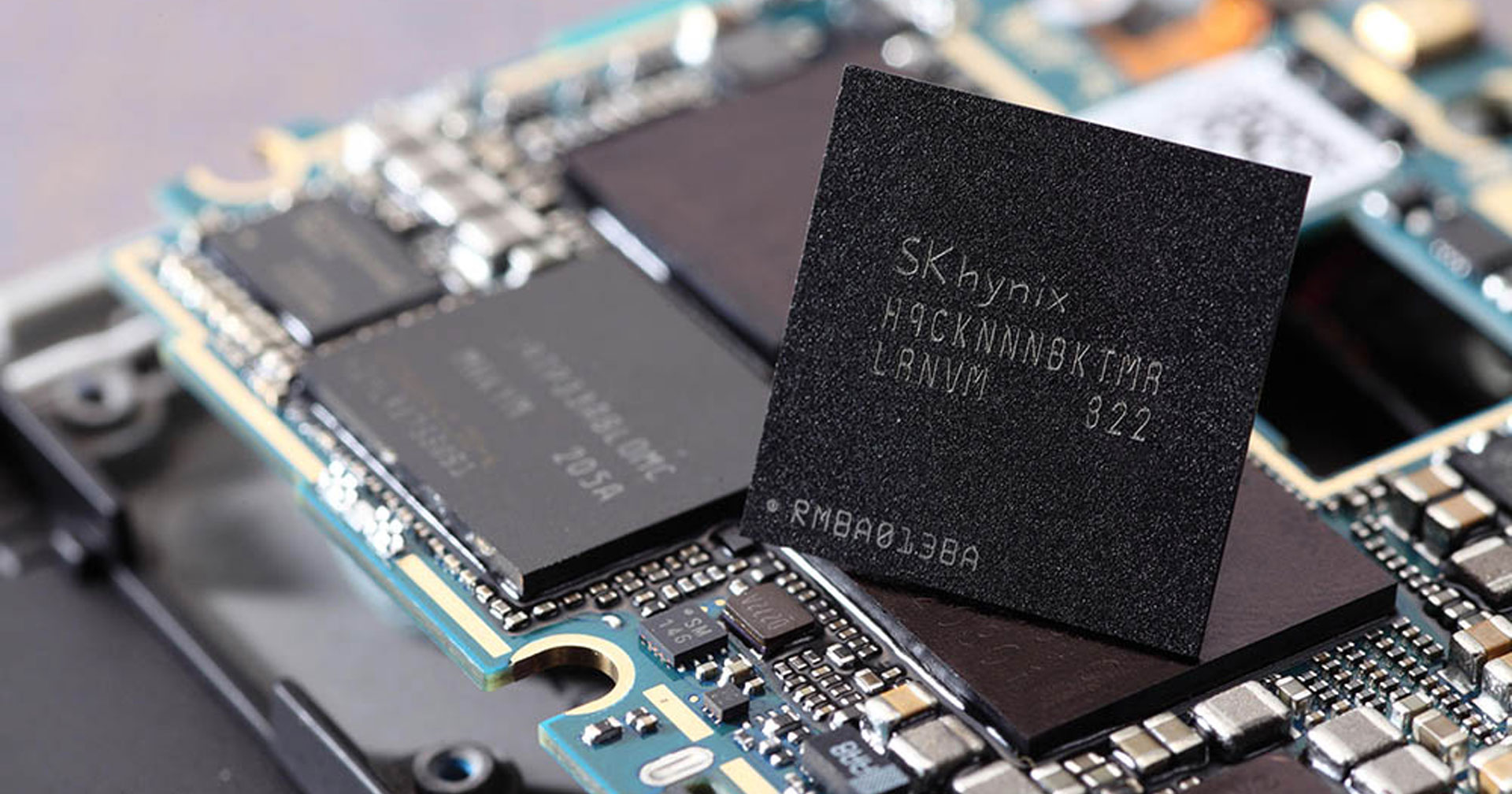

เมื่อวิกฤตชิปขาดแคลนจากกระแส AI ทวีความรุนแรงขึ้น จากการเติบโตและการลงทุนในดาตาเซนเตอร์ทั่วโลก ส่งผลให้ราคา RAM ในตลาดพุ่งสูงอย่างหนัก เนื่องจากผู้ผลิตหลายรายโยกไลน์การผลิตไปเน้นชิปสำหรับดาตาเซนเตอร์ที่ให้ผลกำไรสูงกว่า ทำให้ผลกระทบจึงตกมาสู่ผู้บริโภคทั่ว ๆ ไป… นอกจากฝั่ง PC แล้ว คาดว่าสมาร์ตโฟน และแล็ปท็อปในปีหน้าอาจเป็นรายต่อไปที่จะได้รับผลกระทบ และคาดว่าจะมาพร้อม RAM ที่น้อยลงกว่าในรุ่นปัจจุบัน ปัญหาการขาดแคลนชิปหน่วยความจำทั่วโลกเป็นเรื่องที่มีการรายงานมาอย่างต่อเนื่อง โดยที่ผ่านมาผู้ผลิตส่วนใหญ่เลือกแก้ปัญหาด้วยการปรับขึ้นราคา แต่เมื่อแนวทางนี้เริ่มไปต่อได้ยาก แผนถัดไปจึงอาจเป็นการลดสเปกหน่วยความจำลงแทน ตามข้อมูลจาก Lanzuk สื่อข่าววงการเทคโนโลยีจากเกาหลีใต้ รายงานว่า เราอาจเข้าใกล้จุดที่สมาร์ตโฟนที่มาพร้อม RAM 12GB

เปิด 7 เทรนด์ AI ปี 2569 จาก Microsoft เปลี่ยนบทบาทสู่ 'คู่คิด' ช่วยมนุษย์ทำงาน ลุยนวัตกรรมควอนตัม การแพทย์ และโมเดล Aurora แก้วิกฤตโลกร้อนและน้ำท่วม

ในหลายปีที่ผ่านมา Metaverse หรือโลกเสมือนเป็นประเด็นที่ถูกพูดถึงอย่างมาก บริษัทเทคโนโลยีหลายบริษัทต่างให้ความสำคัญไปที่ Metaverse ในฐานะแพลตฟอร์มยุคถัดไป ซึ่ง Facebook ถึงกับเปลี่ยนชื่อบริษัทเป็น Meta เพื่อเน้นจุดยืนว่าบริษัทจะพัฒนาไปในด้านนี้โดยเฉพาะ

การเกิดขึ้นของ AI สร้างการเปลี่ยนแปลงครั้งใหญ่ต่อโครงสร้างการทำงานของมนุษย์ทั่วโลก โดยเฉพาะประเด็น AI จะเข้ามาแย่งงานมนุษย์หรือไม่

เบราเซอร์เป็นอีกหนึ่งสนามแข่ง AI ของหลายบริษัท ก่อนหน้านี้ทาง OpenAI ได้เปิดตัว ChatGPT Atlas ซึ่งเป็นเบราเซอร์ที่ขับเคลื่อนด้วย AI ซึ่งสนามเบราเซอร์นั้นถือว่าเพิ่งเริ่มต้นเท่านั้น

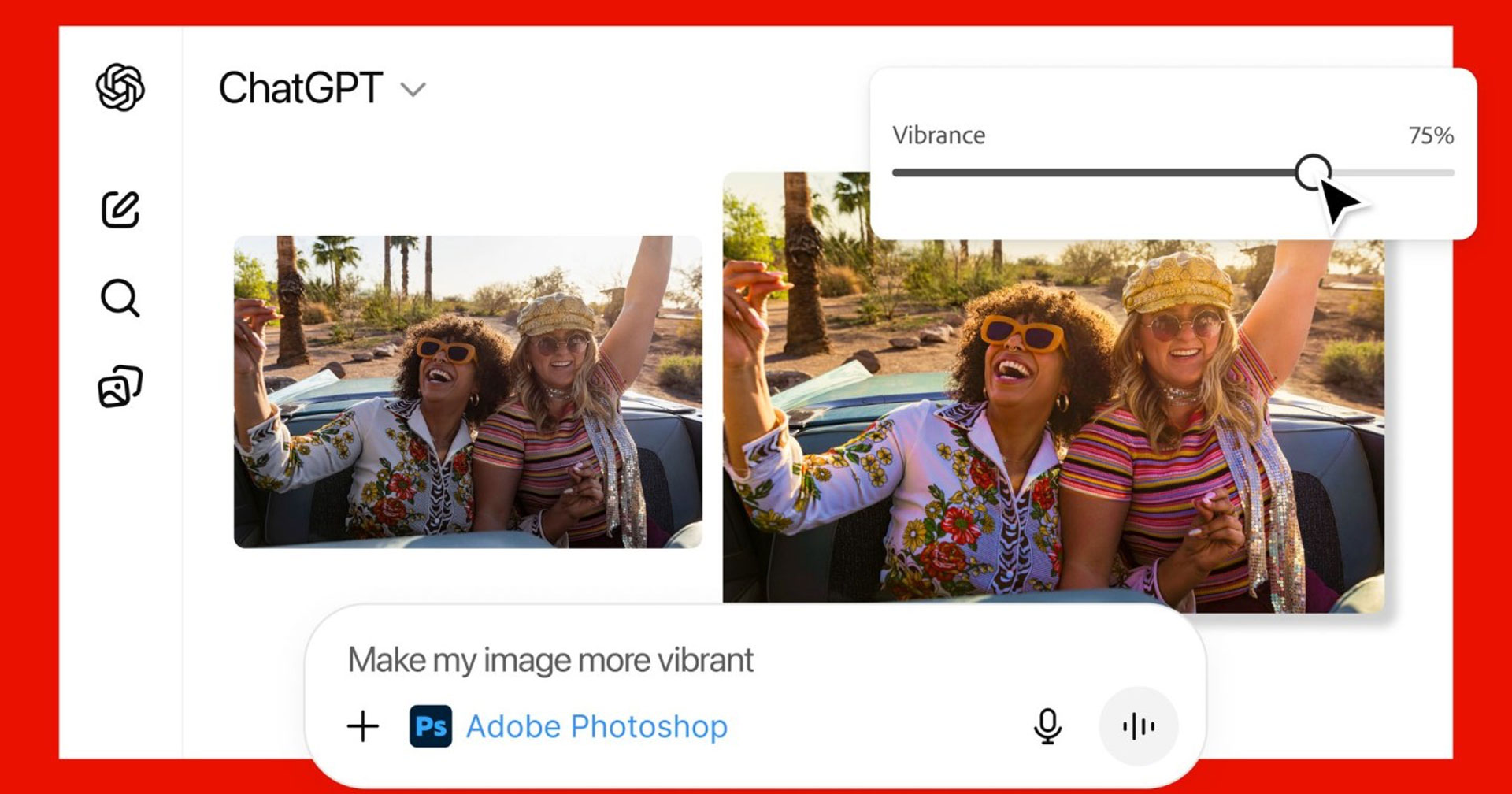

OpenAI จับมือกับ Adobe เปิดตัวฟีเจอร์ใหม่ ผสาน ChatGPT เครื่องมือ AI ยอดฮิตเข้ากับแอปฯกราฟิกระดับมืออาชีพอย่าง Photoshop, Acrobat และ Adobe Express ทำให้ผู้ใช้งานสามารถทำงานได้โดยตรงผ่าน ChatGPT แค่พิมพ์สั่งเท่านั้น การใช้งานก็ง่ายมาก ๆ เพียงกดเชื่อมต่อแอปฯฝั่ง Adobe จากหน้า Setting จากนั้นเราก็จะสามารถพิมพ์เรียกใช้งานแอปฯดังกล่าวได้ทันที พร้อมกับอัปโหลดไฟล์ที่ต้องการแก้ไข และระบุคำสั่งว่าต้องทำอะไรบ้าง ในการใช้งานแอปฯของ Adobe สามารถแสดงตัวเลือกผลลัพธ์หลายแบบให้เราได้เลือก หรือแสดง

กลายเป็นประเด็นไปทั่วโลกเลยทีเดียว หลัง McDonald’s ประเทศเนเธอร์แลนด์ได้ลบโฆษณาที่สร้างด้วย AI ออก หลังจากกระแสต่อต้านอย่างหนัก

OpenAI เปิดตัวโมเดล GPT-5.2 หลังจากซีอีโอ แซม อัลท์แมน ประกาศ “code red” เมื่อต้นเดือนธันวาคม กระตุ้นให้เร่งการพัฒนาโมเดลใหม่เพื่อแข่งขันกับ Gemini 3 ของ Google ที่ขยับเข้าใกล้ขึ้นทุกที เรียกว่าทางบริษัทได้ระงับโครงการที่ไม่ใช่งานหลักเพื่อทุ่มทรัพยากรให้ภารกิจนี้ จนกลายมาเป็นโมเดล GPT-5.2 โดยทาง OpenAI ระบุว่า GPT-5.2 ได้รับการพัฒนาให้ฉลาดขึ้น เข้าใจบริบทระยะยาวได้ดีขึ้น เขียนโค้ดแม่นยำขึ้น และมีศักยภาพในการสร้างคุณค่าทางเศรษฐกิจให้ผู้ใช้ เช่น การสร้างสเปรดชีต งานนำเสนอ