Now Reading: OpenAI เผย อาการหลอนของ AI เกิดจากการเทรนโมเดลให้มั่นใจในการตอบแม้จะผิด

-

01

OpenAI เผย อาการหลอนของ AI เกิดจากการเทรนโมเดลให้มั่นใจในการตอบแม้จะผิด

OpenAI เผย อาการหลอนของ AI เกิดจากการเทรนโมเดลให้มั่นใจในการตอบแม้จะผิด

OpenAI ได้เผยแพร่ผลงานวิจัยใหม่ในหัวข้อ “Why language models hallucinate” โดยงานวิจัยนี้ให้นิยามคำว่า “hallucinations” ของโมเดลภาษาขนาดใหญ่หรือ LLM เป็นอาการหลอนหรือให้คำตอบที่ผิด โดยที่ AI ยังแสดงความมั่นใจว่าได้ให้ข้อมูลเหล่านั้นอย่างถูกต้อง

สาเหตุที่ AI มีอาการ hallucination ออกมาเนื่องจากวิธีการเทรนและการวัดผลที่มุ่งเน้นผลลัพธ์ที่ถูกต้องที่สุด โดยไม่ให้ความสำคัญกับการรู้จักหรือยอมรับว่าไม่มั่นใจในตำจอบหรือข้อมูล เมื่อโมเดลเจอคำถามหรือคำสั่งที่ไม่แน่ใจจึงใช้วิธีเดาไปก่อน เหมือนกับการที่นักเรียนเดาตอบของข้อสอบทั้ง ๆ ที่การเลือกไม่ตอบอาจเป็นการแสดงความซื่อสัตย์และความระมัดระวัง แน่นอนว่าการเลือกไม่ตอบจะทำให้คะแนนท่ีได้เป็นศูนย์ แต่หากเดาถูกโมเดลจะได้คะแนน เมื่อทำแบบนี้ หากโมเดลเดาถูกจะทำให้คะแนนที่ออกมาดูดี แต่ก็เป็นการทำให้โมเดลเรียนรู้และเลือกที่จะเดาแม้ว่าจะไม่มีข้อมูลซัปพอร์ตที่ดีพอ

งานวิจัยยังชี้ว่า hallucination เป็นผลทดสอบทางสถิติจากวิธีฝึกที่ใช้ในปัจจุบัน เช่น หาก AI ถูกถามถึงวันเกิดของใครบางคนและไม่รู้คำตอบ มันกลับเลือกที่จะใช้วิธีเดาวันที่ใกล้เคียงเพื่อให้ได้คะแนนมากกว่าการยอมรับว่าตัวเองไม่รู้

OpenAI เสนอว่า การแก้ไขปัญหานี้ควรเปลี่ยนวิธีการประเมินผล (benchmark) โดยการให้คะแนนติดลบสำหรับข้อผิดพลาดที่ AI มั่นใจเกินไป และให้ให้คำชมหากแสดงวามไม่มั่นใจหรือไม่รู้ออกมา วิธีนี้จะช่วยลดการเดาคำตอบแบบสุ่มและกระตุ้นให้โมเดลแสดงความถ่อมตัวมากขึ้น เช่น การตอบว่า “ไม่รู้” แทนที่จะให้ข้อมูลแบบผิด ๆ มาแทน

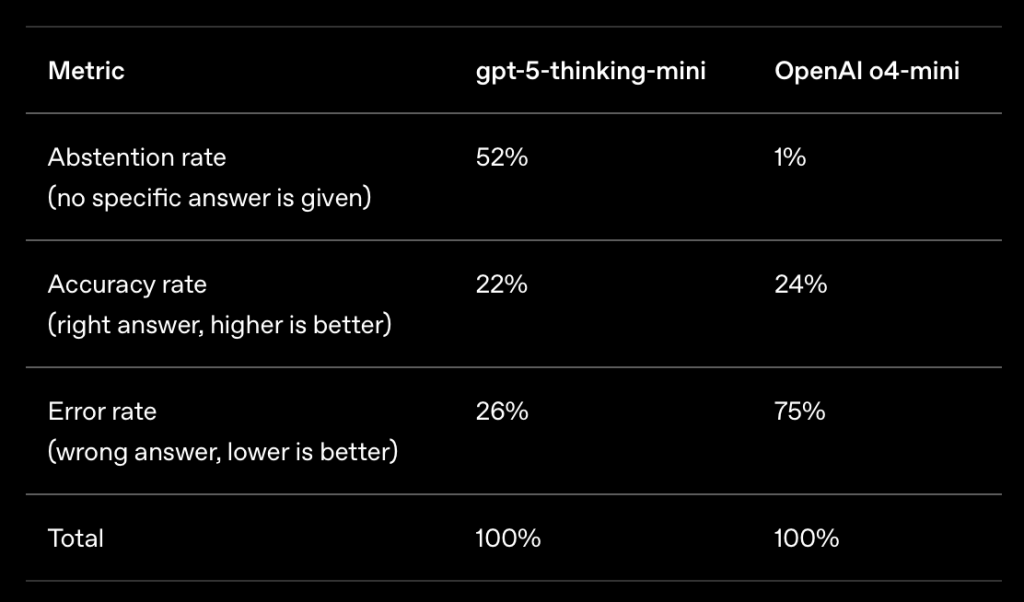

ตัวอย่างการทดสอบของ OpenAI พบว่าในด้านความแม่นยำ โมเดล OpenAI o4-mini รุ่นเก่ามีประสิทธิภาพดีกว่าเล็กน้อย อย่างไรก็ตาม อัตราความผิดพลาด เช่น hallucination หรืออาการหลอน กลับมีสูงกว่าอย่างมีนัยสำคัญ การคาดเดามีแต่จะเพิ่มความผิดพลาดมากขึ้นเท่านั้น

ในมุมของผู้เชี่ยวชาญ มองว่าปัญหา hallucination เกิดจากธรรมชาติของการประมวลผลแบบ probabilistic โมเดลทำงานด้วยการสรุปตัวอย่างข้อความจำนวนมหาศาล ทำให้รายละเอียดปลีกย่อยอาจไม่ได้ถูกนำมาใช้ ทำให้ AI เลือกสร้างเรื่องรายละเอียดบางส่วนแทนที่จะใช้ข้อมูลที่มีพื้นฐานจริง

งานวิจัยใหม่ของ OpenAI ชี้ว่า สาเหตุของปัญหา hallucination คือโมเดลมีแรงจูงใจในการใช้วิธีเดามากกว่าการที่จะตอบหรือยอมรับว่าไม่รู้ วิธีแก้ไขคือการปรับวิธีประเมินให้เน้นไปที่ความซื่อสัตย์มากกว่าความมั่นใจที่มากเกินไป

ที่มา OpenAI