Now Reading: ผู้ใช้เบราว์เซอร์ AI เสี่ยง! OpenAI ยอมรับ แก้ปัญหาโดนโจมตีผ่าน Prompt Injection ได้ยาก

-

01

ผู้ใช้เบราว์เซอร์ AI เสี่ยง! OpenAI ยอมรับ แก้ปัญหาโดนโจมตีผ่าน Prompt Injection ได้ยาก

ผู้ใช้เบราว์เซอร์ AI เสี่ยง! OpenAI ยอมรับ แก้ปัญหาโดนโจมตีผ่าน Prompt Injection ได้ยาก

อาชญากรไซเบอร์ไม่จำเป็นต้องพึ่งมัลแวร์หรือช่องโหว่เพื่อเจาะระบบอีกต่อไป เพียงแค่ใช้ “ prompt” ใน “บริบทที่เหมาะสม” ก็โจมตีเบราว์เซอร์ AI ของเป้าหมายได้แล้ว

ก่อนหน้านี้ ศูนย์ความปลอดภัยไซเบอร์แห่งชาติของสหราชอาณาจักร (NCSC) ก็เคยเตือนเช่นกันว่า การโจมตี Prompt Injection ต่อระบบ Generative AI อาจไม่มีทางแก้ที่เด็ดขาด

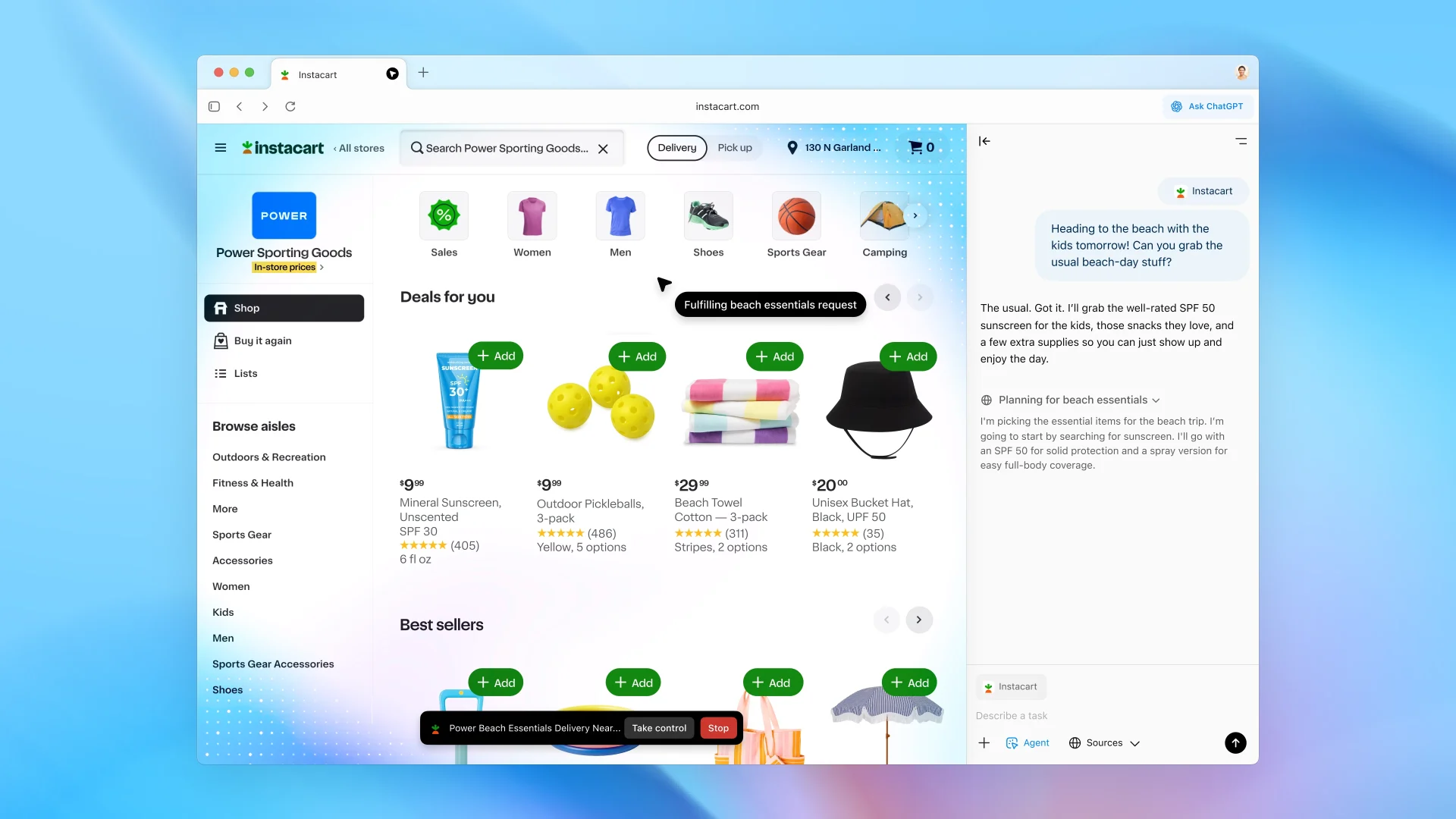

ด้าน OpenAI ออกมายอมรับตรงๆ ว่า การโจมตีเบราว์เซอร์ AI ไม่ใช่ปัญหาที่สามารถแก้ไขให้หมดไปได้ แต่เป็นความเสี่ยงระยะยาวที่หลีกเลี่ยงไม่ได้ พร้อมยอมรับว่า “โหมดเอเจนต์” ในเบราว์เซอร์ ChatGPT Atlas ยิ่งเพิ่มโอกาสการโจมตีให้กว้างขึ้น

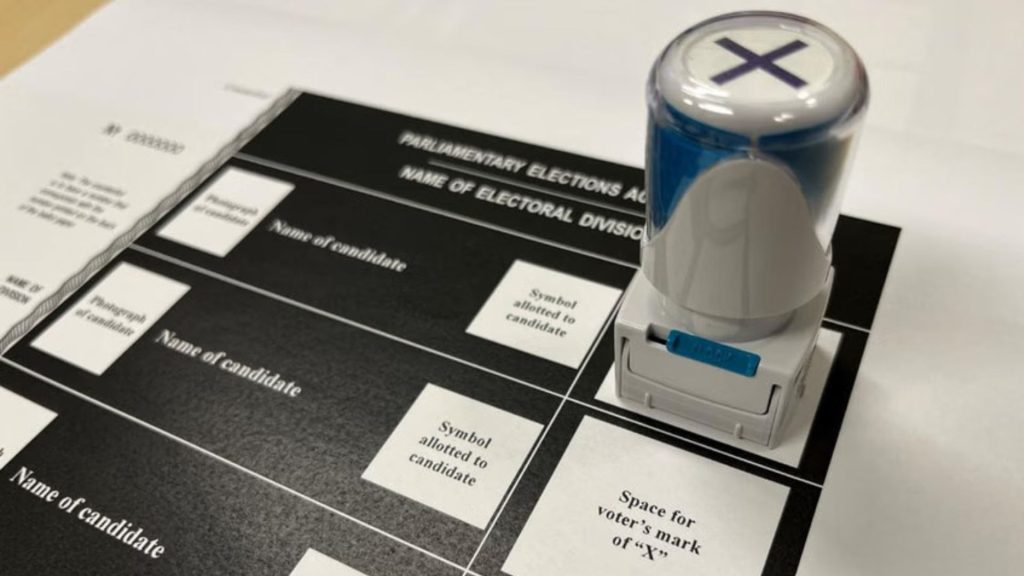

การโจมตีแบบ Prompt Injection อาศัยการซ่อนคำสั่งไว้ในหน้าเว็บ เอกสาร หรืออีเมลในลักษณะที่มนุษย์มองไม่เห็น แต่ AI สามารถ “อ่าน” และตีความได้ เมื่อเอเจนต์ AI ประมวลผลเนื้อหานั้น มันอาจปฏิบัติตามคำสั่งที่เป็นอันตรายโดยไม่รู้ตัว

ตอนนี้เครื่องมือ AI สามารถเข้าถึงข้อมูลส่วนตัวได้มากกว่าเดิม เมื่อรวมกับผู้ใช้เปิดทางให้เอเจนต์ AI ทำงานบนเว็บสาธารณะก็ทำให้เกิดความกังวลมากขึ้น

ทางเลือกกับความเสี่ยงของเบราว์เซอร์ AI

OpenAI มองว่า Prompt Injection เป็นความท้าทายระยะยาวที่ต้องรับมืออย่างต่อเนื่อง ไม่สามารถแก้ด้วยแพตช์เพียงครั้งเดียว แนวทางของบริษัทคือการอัปเดตอย่างรวดเร็ว การทดสอบอย่างสม่ำเสมอ และการใช้ระบบป้องกันหลายชั้น ซึ่งสอดคล้องกับแนวคิดของ Anthropic และ Google ที่เห็นตรงกันว่า เอเจนต์ AI ต้องถูกควบคุมด้วยสถาปัตยกรรมที่รัดกุมและการทดสอบความทนทานอย่างต่อเนื่อง

สิ่งที่ OpenAI ใช้แตกต่างออกไปคือ การฝึก AI ให้ทำหน้าที่เหมือนแฮ็กเกอร์ ด้วยเทคนิคการเรียนรู้แบบเสริมแรง (Reinforcement Learning) เอเจนต์นี้จะพยายามหาวิธีแทรกคำสั่งอันตรายเข้าไปในกระบวนการทำงานของ AI ตัวอื่น

ระบบจะเริ่มโจมตีในสภาพแวดล้อมจำลอง คาดการณ์วิธีคิด การตัดสินใจ และจุดอ่อนของ AI เป้าหมาย จากนั้นปรับปรุงวิธีโจมตีและลองใหม่ซ้ำๆ ด้วยความเข้าใจเชิงลึกต่อกระบวนการภายในของ AI ซึ่ง OpenAI เชื่อว่าวิธีนี้ช่วยค้นหาช่องโหว่ได้เร็วกว่าการรอให้ผู้โจมตีจริงลงมือ

แม้จะมีมาตรการป้องกันเหล่านี้ เบราว์เซอร์ AI ก็ยังไม่อาจเรียกว่าปลอดภัยได้อย่างแท้จริง เนื่องจากความเป็นอิสระในการตัดสินใจ และ การเข้าถึงข้อมูลโดยตรง นั่นหมายความว่า คำสั่งอันตรายเพียงคำเดียวที่ถูกซ่อนไว้อย่างแนบเนียน อาจส่งผลต่อการกระทำของ AI ได้โดยที่ผู้ใช้ไม่ทันสังเกต แม้จะมีระบบป้องกันมากเพียงใด เอเจนต์เหล่านี้ก็ยังต้องพึ่งพาความไว้วางใจในเนื้อหาจำนวนมหาศาล และความไว้วางใจนั้นเองที่อาจถูกบิดเบือนได้เสมอ

ที่มา foxnews